Vol enthousiasme ben je begonnen met conversie optimalisatie. Je hebt meerdere varianten van een bepaalde pagina tegelijk getest als landingspagina (een A/B test). En nu? Nu heb je als het goed is veel data verzameld, die moet geanalyseerd worden. In deze blog leggen we je uit hoe je dit aan kunt pakken.

A/B tests analyseren

A/B watte?

Zegt dit je allemaal he-lemaal niks? Dat is niet erg hoor, dan ben je misschien beter geholpen met ons stappenplan over conversie optimalisatie. Daar leren we je hoe je zelf je website verbeterd door experimenten te maken. Als je dat onder de knie hebt kun je weer terugkomen bij deze blog.

Je testdata terugvinden

Hiervoor gaan we ervan uit dat je Google Optimize gebruikt. Heb je een andere tool gebruikt? Het principe van data analyseren blijft natuurlijk hetzelfde. Open je Google Optimize account en je vindt daar het totaaloverzicht met testen. Klik op de test die je hebt gemaakt en je gaat direct naar het rapportage gedeelte. Klik op de test en je krijgt de data te zien.

De cijfers per variant analyseren

Op basis van het doel wat je hebt ingesteld krijg je te zien welke variant het beste presteerde tot nu toe. Zoiets:

Resultaat per dag bekijken & analyseren

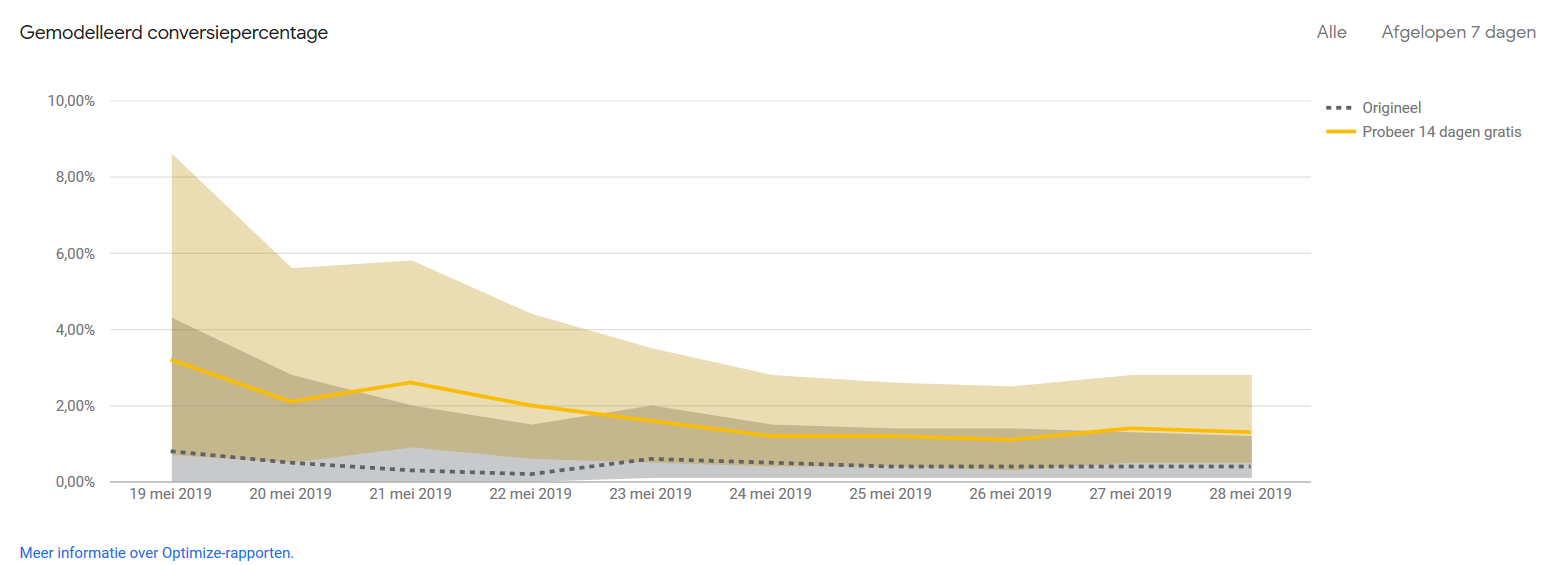

Als je benieuwd bent hoe de testvariant – of het origineel – hebben gepresteerd met verloop van tijd kun je dit ook zien in het overzicht. Handig: want zo kun je bijvoorbeeld onderzoeken via welke variant welke aanvraag binnenkwam. Mits het er niet meer dan één per dag zijn. Zo kun je de aanvragen – of bijvoorbeeld leads – ook op kwaliteit beoordelen.

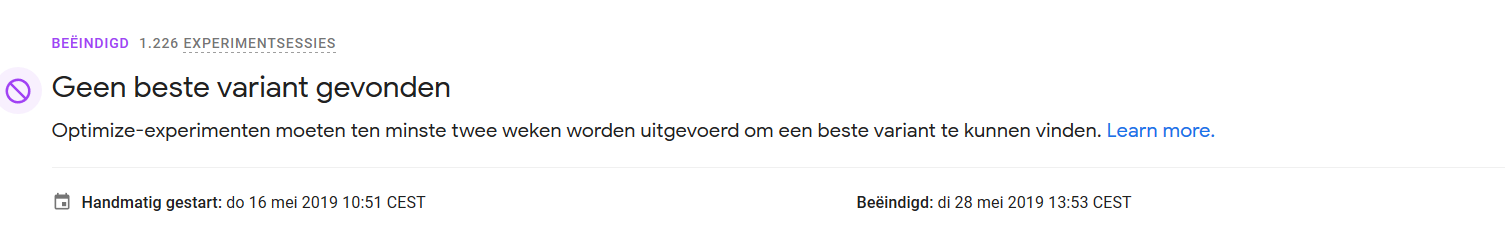

De analyse die Google Optimize voor je doet

Om ondernemers en marketeers te helpen zal Google Optimize zelf ook zijn conclusie trekken over de test. In dit voorbeeld zien we dat Google de test niet als betrouwbaar beschouwd omdat hij nog geen 2 weken heeft gelopen. Echter was het verschil tussen de varianten na 9 dagen al zo groot dat we besloten hebben de nieuwe variant toch al door te voeren – op verzoek van de klant. Dit ging tegen het algoritme van Google in, die de test vervolgens afkeurde. Begrijpelijk. Echter laat dit wel zien dat de analyse van een algoritme dus niet altijd ideaal is!

Zelf de test analyseren

Als beginner is het natuurlijk het handigst het advies van Google zelf te volgen. Echter is het jouw taak om de context van je organisatie en je doelen goed te begrijpen. Als een variant bijvoorbeeld veel meer sales oplevert – die vervolgens allemaal retour worden gestuurd kun je alsnog beter de oude variant gebruiken. Kijk dus verder dan de data van Google zelf en plaats het in de juiste context.

Voorkom confirmation bias

We willen allemaal graag dat onze ideeën slagen. Dit heet confirmation bias. Het is daarom belangrijk om tijdens een analyse je trots opzij te zetten en echt puur te kijken naar resultaat. Is jouw idee de mindere? Laat je niet uit het veld slaan en verzin een nieuwe.

Let op: niet elke A/B test is betrouwbaar

Tot nu toe zijn we ervan uitgegaan dat je test ook betrouwbaar was. Echter ook cijfers kunnen vertekenen. Je A/B test is waarschijnlijk onbetrouwbaar wanneer:

- Het verschil in doelen te klein is – 3 vergeleken met 4 aanvragen is 25% stijging maar zegt niks.

- Het verkeer op de varianten te weinig is, mik op minimaal 1000 bezoekers.

- Het verkeer over de varianten niet gelijk verdeeld is

- De doelgroep van de varianten anders was

- De looptijd is langer dan twee weken – maximaal 2 weken is bijna altijd het beste i.v.m. het verversen van cookies

De meeste van deze zaken kun je natuurlijk van tevoren voorkomen, controleer echter altijd of het toch niet mis is gegaan. Blijf kritisch naar je data kijken, ook als bovenstaande goed zit.

Hoe ga je met deze cijfers om?

Dat is de hamvraag. Meten is weten. Op basis van je analyse wil je natuurlijk knopen doorhakken. Maar iedere situatie is uniek en vraagt om een andere aanpak. In brede zin zijn er echter altijd een paar keuzes:

- Een geslaagde wijziging definitief doorvoeren doe je wanneer het resultaat naar wens is.

- Wil je een nieuwe test verzinnen als het resultaat van de vorige test al heel goed is? Dan kun je je afvragen of je niet beter een andere pagina moet verbeteren. Don’t change a winning team, maar breid je selectie wel uit.

- Gebruik de nieuwe kennis van je klant om andere zaken te verbeteren. Vindt men bijvoorbeeld ‘gratis proberen’ veel interessanter dan ‘gratis demo’ dan kan dit ook gevolgen hebben voor wat je daadwerkelijk aanbied.

- Terug naar de tekentafel: werken je experimenten maar niet? Dan kan het ook een kwestie van vraag en aanbod zijn. Durf kritisch te zijn. Ook richting je eigen organisatie en probeer dit klantgerichter te maken.

Vind je dat lastig? Download ons gratis stappenplan hieronder:

Gratis whitepaper AB testen & CRO

Ik snap er nog steeds niks van

Heb je nog steeds geen idee waar we het over hebben? Dan is het misschien handig dat we met elkaar bellen! Wij hebben namelijk de kennis en mankracht om A/B testen voor je op te pakken en te vertalen naar praktische wijzigingen op je website. Dit doen we al voor veel bedrijven waarbij een doelgerichte, flexibele aanpak altijd centraal staat. Klinkt dat interessant?

Meer informatie over dit onderwerp? Margreet maakt je volledig webwijs. Keertje afspreken?

Neem contact opMogen we jou ook webwijs maken? We zitten vol frisse ideeën waar we jou graag verder mee helpen.

Daag ons uit